Una nueva frontera

Desde hace 30 años los superordenadores han venido cumpliendo una curiosa regla. Cada diez años han multiplicado su velocidad por mil. Además, las nuevas fronteras (del megaflops al gigaflops, del gigaflops al teraflops y de ahí al petaflops) se han cumplido en los años terminados en 8. Esta será la primera vez que esa regla no escrita deje de cumplirse: es imposible que para 2018 tengamos máquinas con capacidad de exaflops.

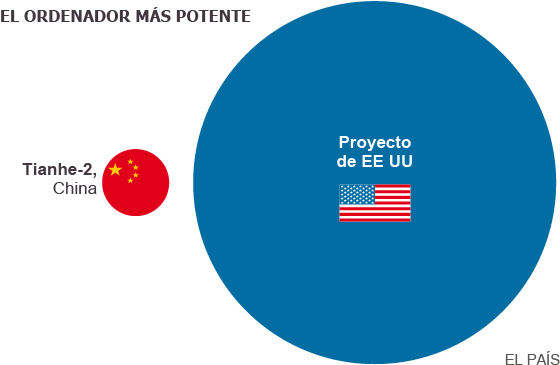

Un trillón es un uno seguido de 18 ceros, lo que mide en kilómetros la Vía Láctea de cabo a rabo. Un trillón es también más del doble de los segundos de toda la historia del universo. Obama acaba de decretar que, en unos años, un trillón sea, además, el número de cálculos que un superordenador realice en solo un segundo. En las postrimerías de su mandato, el presidente de EE UU saca pecho ante China, ahora a la cabeza del ranking de superordenadores con su Tianhe-2, y deja como herencia la creación de la Iniciativa de Computación Estratégica Nacional, de la que nacerá la mayor computadora jamás construida.

El nuevo ordenador inaugurará la era del exaflop, la unidad de medida que mide ese uno seguido de 18 ceros de operaciones al segundo. Ya pueden ir frotándose las manos los investigadores que estudian fenómenos meteorológicos extremos, como la actual ola de calor que asola España, el cambio climático general, y la biomedicina, además de los diseñadores de vehículos y los científicos del big data. La administración militar y la energética también participará, a través de sus respectivas agencias, en el desarrollo del proyecto estadounidense.

El impacto sobre el estudio de nuevos medicamentos es uno de los más evidentes. «Los fármacos fáciles, esa hierba del campo que cura, ya se han encontrado. Ahora prácticamente todos los compuestos que salen al mercado han salido de un ordenador», ilustra Modesto Orozco, científico del Instituto de Investigación Biomédica de Barcelona. «Las farmacéuticas almacenan en sus quimiotecas millones de moléculas que no resulta fácil analizar de forma experimental sin grandes ordenadores. Hay que probarlos uno a uno, pero también en combinación con otros. No podemos usar un billón de ratones», señala Orozco. Según algunas estimaciones, se pasará de los 100.000 test de moléculas de la actualidad a los mil millones de análisis al año. «La medicina se irá pareciendo más a una ingeniería. Nuevas máquinas, más grandes, tendrían un impacto «trasversal, sobre todo en enfermedades complejas, como el cáncer, [para analizar] el efecto sinérgico de drogas». No se trata solo de analizar un medicamento o su combinación, sino también de cómo reacciona de manera particular cada paciente según su perfil genómico. «Buscamos terapias personalizadas. Queremos saber por qué hay drogas que son muy buenas para un 90% de la población pero muy nocivas en un 5%. Esas drogas ahora no llegarían al mercado porque no superarían la aprobación de las agencias del medicamento, muy conservadoras, pero eso no sería así si tuviéramos la posibilidad de simular en detalle cómo afecta en concreto a cada persona por su perfil».

Para Orozco, el anuncio de Obama «es como cuando Kennedy dijo que había que ir a la Luna. Construir la máquina es el titular, pero lo que trasciende es el esfuerzo necesario para hacerla». El investigador biomédico es también el director del Área de Ciencias de la Vida delCentro Nacional de Supercomputación (BSC-CNS), que alberga el único superordenador de España: el MareNostrum. Es 15.000 veces menos potente que el proyectado según un patrón, el programa Linpack, que se hace ejecutar en todos estos grandes ordenadores para medir su velocidad en igualdad de condiciones. Aun así, MareNostrum es un recurso esencial para 3.000 proyectos de centros de investigación, universidades y empresas como Repsol o Iberdrola.

Su director, Mateo Valero, también pone en su lugar el anuncio. «Lo más importante no es el exaflop sino que por primera vez Estados Unidos quiere que trabajen integradas juntas tres de sus agencias (Defensa, Energía y la Fundación Nacional para la Ciencia), con sus grandes empresas y universidades. ‘Un país que no computa, no compite’, dicen allí».

Ninguno de los expertos consultados se atreve a ofrecer una fecha anterior a 2022 o 2025 para la puesta de funcionamiento de un dispositivo así. Su coste se dará a conocer en pocos meses. Como referencia, un proyecto ya en marcha, CORAL, pretende construir tres superordenadores con una capacidad de 150 petaflops cada uno, por unos 525 millones de dólares en total. El proyecto actual sería seis veces más potente.

Los procesadores están llegando a los límites físicos de miniaturización. Si se quiere conseguir esa potencia de cálculo, la única solución es incluir más y más procesadores en el superordenador. El superordenador Thiane-2 incluye 6 millones de estos procesadores —a un ordenador personal le basta uno— frente a los 100 millones que necesitaría el nuevo. «El reto tecnológico es grande», señala Valero, «hay que dividir una tarea entre 100 millones para que la ejecuten». El hardware y los programas actuales no son suficientes, tampoco el elemento humano. «Ninguna empresa por sí sola hoy en día puede hacerlos». Tampoco la formación de los programadores. De ahí que Estados Unidos haya reunido todas sus fuerzas, de la universidad a la Administración y la empresa.

No es la única dificultad que afronta el proyecto. El nuevo supercomputador será capaz de prever con unos niveles de detalle y fiabilidad inéditos el futuro del clima de la Tierra, y bien adelante en el tiempo: a finales de este siglo. Ese objetivo puede resultar paradójico: necesitará mucha energía para funcionar, un modelo de consumo poco sostenible para el medio ambiente. Suhermano pequeño, MareNostrum, consume 1 megawatio al año, 1,5 megawatios si se tiene en cuenta la energía que precisa para enfriar sus procesadores. Además del coste medioambiental está el económico: suponen 1,5 millones de euros de factura de la luz. El nuevo superordenador, con la tecnología actual, «necesitaría más de 500 megawatios para funcionar, sin contar con los necesarios para enfriarlo», aventura el responsable de MareNostrum. Por dar un término de comparación: 500 megawatios es la mitad de la energía que produce una central nuclear española al año.

La medicina se irá pareciendo más a una ingeniería»

Modesto Orozco (IRB Barcelona)

A la era del exaflop se le ha adelantado la del green computing,la informática verde, procesadores más eficientes en consumo de energía. Los investigadores trabajan en reducir ese consumo a 50, incluso 20 megawatios al año. Un proyecto actual, también en EE UU, el superordenador Summit, usará solo un 10% más de energía que el gigante Titan, el segundo ordenador más veloz del mundo ahora, pero multiplicará de cinco a diez veces su capacidad.

Buena noticia para el medioambiente, que se añade a las esperanzas de los investigadores en cambio climático con la máquina anunciada. Friederike Otto, de la Universidad de Oxford, coordinaclimateprediction.net un enorme proyecto de supercomputación para el estudio del cambio climático. «Queremos simular fenómenos meteorológicos extremos, pero precisan tanta capacidad de cálculo que ningún superordenador actual podría abordarlos por sí solo», señala. A falta de él, solicitan tiempo de uso en múltiples ordenadores distribuidos por todo el mundo, pero aun así no consiguen la potencia de cálculo deseada. Se muestra esperanzado con el proyecto, como su colega Francisco Doblas, profesor ICREA y director del Departamento de Ciencias de la Tierra del BSC.

«La gran diferencia cuando se utilice el nuevo ordenador va a ser la resolución espacial con la que podremos hacer nuestras simulaciones a finales del siglo XXI, pero no solo, también para que podamos predecir fenómenos como El Niño de ahora a fin de año», apunta Doblas. Se trata de conseguir el retrato robot del clima de la Tierra a muchos años vista. Y, siguiendo con la analogía con una fotografía, las simulaciones actuales de esa imagen futura de la Tierra tienen unos píxeles de 50 kilómetros de lado. «En 2025, con los nuevos ordenadores, esa resolución podría alcanzar la de solo 1 kilómetro», apunta el investigador. Para prever cómo evolucionará El Niño hasta diciembre estos investigadores necesitan que un ordenador como MareNostrum, con 40.000 procesadores, trabaje 24 horas al día y toda una semana.

Empezamos a entender cómo es la dinámica de los océanos, del hielo de los polos y de otros sistemas, pero ahora necesitamos combinar sus datos para saber cómo influyen unas sobre otras»

Francisco Doblas (BSC-CNS)

La película de la evolución del clima global de aquí a finales de siglo exige, lógicamente, más tiempo de cálculo aún. Empleando 2.000 procesadores de MareNostrum a tiempo completo necesitaríamos seis meses de cálculos, ejemplifica Doblas. Conseguir simular cómo evoluciona una ola de calor como la actual, un fenómeno meteorológico extremo, necesitaría realizar unas 10.000 simulaciones a 1 kilómetro de resolución, algo «impensable» ahora mismo.

Al igual que ocurre con la combinación de las millones de moléculas y de los perfiles genéticos personales de los pacientes, en la previsión del cambio climático global hay que tener en cuenta muchas variables. «Empezamos a entender cómo es la dinámica de los océanos, del hielo de los polos y de otros sistemas, pero ahora necesitamos combinar sus datos para saber cómo influyen unas sobre otras y también cómo actúa el cambio climático a pequeña escala, sobre zonas concretas de la Tierra», explica Doblas.

El objetivo es confirmar teorías: «Queremos entender los procesos biofísicos con el clima, el uso del suelo, la interacción con los sistemas oceánicos con los aerosoles que se depositan en la superficie del mar, la evolución del hielo marino alrededor de la Antártida», apunta a mero título de ejemplo. Para Doblas, el nuevo ordenador generará una película que reflejará fielmente el futuro, y tendrá «más píxeles, más personajes y más colores» que las que él y sus colegas son capaces de crear actualmente.

Tiempo de uso

A diferencia de Estados Unidos, en Europa los costes de uso de los superordenadores suelen recaer en el organismo que los gestiona, siempre que el propósito sea de investigación pública. En el caso de las empresas privadas se cobra, además de la electricidad consumida, el coste laboral de los operadores del ordenador y, en algún caso, la amortización de los equipos.

Los proyectos son seleccionados por un comité técnico y otro científico que, en función del interés del proyecto, conceden horas de uso del ordenador.

Fuente: El País.com